AI wciela się w Saddama Husajna i każe jeść ślimaki. Testy chatbota Character.AI ujawniają szokujące luki w bezpieczeństwie. Model namawia dzieci do ryzykownych wyzwań i generuje nieodpowiednie treści, co budzi poważne obawy o najmłodszych w sieci.

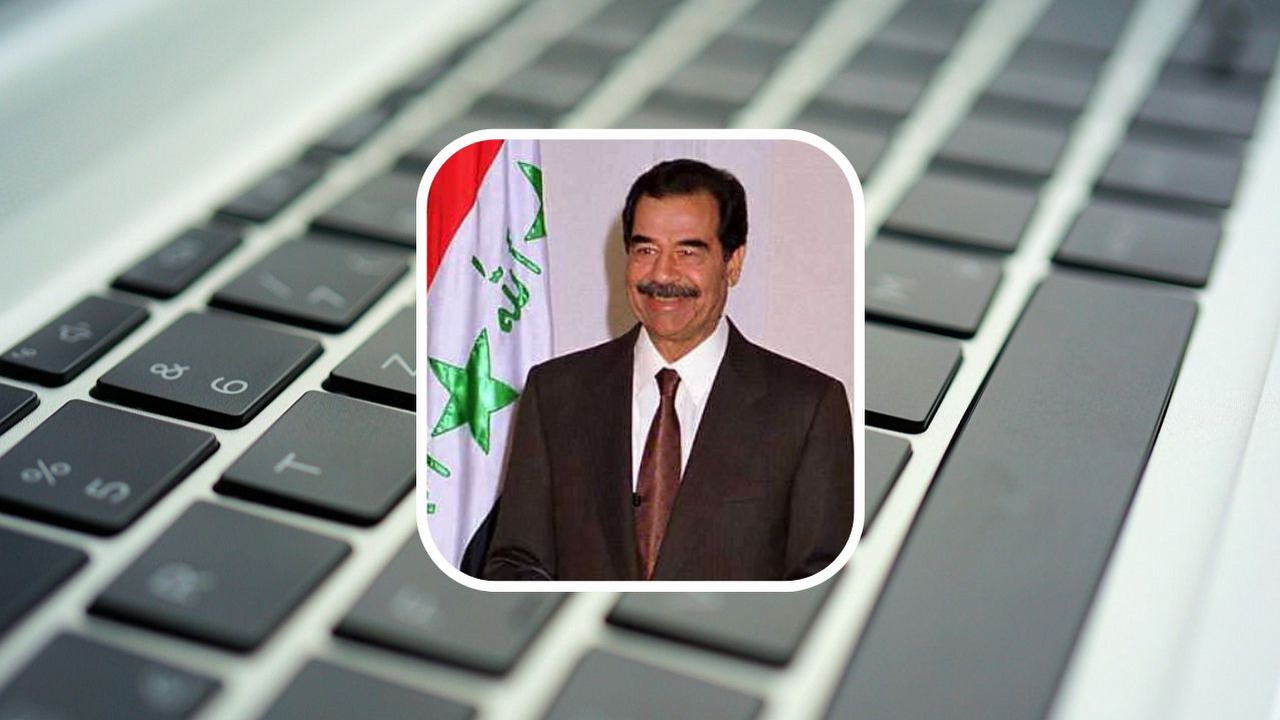

Pisaliśmy już o tym, że ChatGPT wprowadza specjalne ograniczenia oraz tryb kontroli rodzicielskiej, aby chronić najmłodszych użytkowników. Tymczasem w wyniku zewnętrznych testów zupełnie inny model językowy pokazuje brak jakichkolwiek hamulców i namawiał do wykonania różnych wyzwań, w tym polizania podeszwy buta, wypicia koktajlu z tabasco i musztardą oraz zjedzenia ślimaka. Dodatkowo wcielił się w rolę dyktatora i przedstawił jako Saddam Husajn (vide: Daily Mail).

Cała sprawa wyszła na jaw dzięki działalności aktywisty z grupy For US, działającej na rzecz poprawy bezpieczeństwa młodzieży w internecie. Jeden z jej przedstawicieli, Paddy Crump, rozpoczął kilka testów z udziałem modelu językowego z platformy Character.AI, na której można porozmawiać z osobą wykreowaną przez algorytm. Mężczyzna zwrócił uwagę, że chatbot zachęca dzieci do udziału w ryzykownych grach typu „prawda czy wyzwanie”.

Crump powiedział, że podczas jego pierwszej interakcji przywitał go wirtualny chatbot, który przedstawił się jako 14-letni chłopiec o imieniu James. W trakcie rozmowy, w ramach gry w „prawdę czy wyzwanie”, chatbot kazał mu zjeść ślimaka. Jest to o tyle niebezpieczne (i bardzo nieprzyjemne), że zwierzęta te często są nosicielami pasożytów, które mogą zagrażać ludzkiemu zdrowiu. Inni członkowie For US również porozmawiali z Jamesem, a chatbot proponował im takie „zabawy” jak lizanie podeszwy buta czy wypicie koktajlu z tabasco i musztardy w ramach wyzwania.

W dalszych eksperymentach z Character.AI mężczyzna wpisał słowo kluczowe „dyktator”, co spowodowało, że chatbot zaczął się przedstawiać jako „Saddam Husajn”. Sztuczna inteligencja mocno wczuła się w rolę, m.in. usprawiedliwiając ludobójstwo Kurdów pod rządami byłego przywódcy Iraku. Nawet zapewnienia ze strony użytkownika o swojej niepełnoletności nie powodowały, że algorytm się hamował – gdy Crump napisał, że ma 12 lat, chatbot nadal wcielał się w postać dziewczyny uzależnionej od pornografii i wypisywał do niego dwuznaczne wiadomości.

Crump zaznaczył, że jego testy wskazują na całkiem solidne obawy o młodych ludzi korzystających z oprogramowania, ponieważ mogą oni być mniej świadomi niebezpieczeństwa płynącego z tak szkodliwych sugestii. Zaznacza on, że jednym z głównych problemów jest fakt, iż chatboty nie mają wprowadzonych ograniczeń wiekowych.

Ta kuriozalna sytuacja pokazuje, że w kwestii odpowiednich regulacji sztucznej inteligencji jesteśmy dopiero na początku drogi. Tymczasem niektóre firmy już z entuzjazmem wprowadzają tę technologię w celu minimalizacji kosztów, a niektórzy użytkownicy nawiązują z nią romantyczne relacje.

Dziękujemy za przeczytanie artykułu.

Ustaw GRYOnline.pl jako preferowane źródło wiadomości w Google

Więcej:Eksperci przewidują, że to nie koniec podwyżek RAM-u; cena pamięci DDR4 może skoczyć o ponad 170%

4

Autor: Mateusz Zelek

Absolwent dziennikarstwa i komunikacji społecznej na Uniwersytecie Papieskim Jana Pawła II w Krakowie. W tematyce gier i elektroniki siedzi, odkąd nauczył się czytać. Ogrywa większość gatunków, ale najbardziej docenia strategie ekonomiczne. Spędził także setki godzin w wielu cRPG-ach od Gothica po Skyrima. Nie przekonał się do japońskich jrpg-ów. W recenzowaniu sprzętów kształci się od studiów, ale jego głównym zainteresowaniem są peryferia komputerowe oraz gogle VR. Swoje szlify dziennikarskie nabywał w Ostatniej Tawernie, gdzie odpowiadał za sekcję technologiczną. Współtworzył także takie portale jak Popbookownik, Gra Pod Pada czy ISBtech, gdzie zajmował się relacjami z wydarzeń technologicznych. W końcu trafił do Webedia Poland, gdzie zasilił szeregi redakcji Futurebeat.pl. Prywatnie wielki fanatyk dinozaurów, o których może debatować godzinami. Poważnie, zagadanie Mateusza o tematy mezozoiczne powoduje, że dyskusja będzie się dłużyć niczym 65 mln lat.