Jak sobie radzi nowy model GPT-5 w starciu z konkurencją w postaci Gemini, Copilota i Claude? Okazuje się, że nie zawsze zwycięsko. W krótkim teście zajął ostatnie miejsce, co wydaje się co najmniej dziwne.

GPT-5 to najnowszy model językowy od OpenAI, na którym działa m.in. popularny chatbot ChatGPT. Jest on najbardziej zaawansowany jak dotąd i najbardziej uniwersalny.

Nie ma potrzeby wyboru modelu odpowiedniego dla swojego zapytania, GPT-5 integruje wszystkie poprzednie wersje. Niekoniecznie jednak jest to najlepsza obecnie sztuczna inteligencja, czego dowiódł redaktor serwisu GameStar wykonując prosty test.

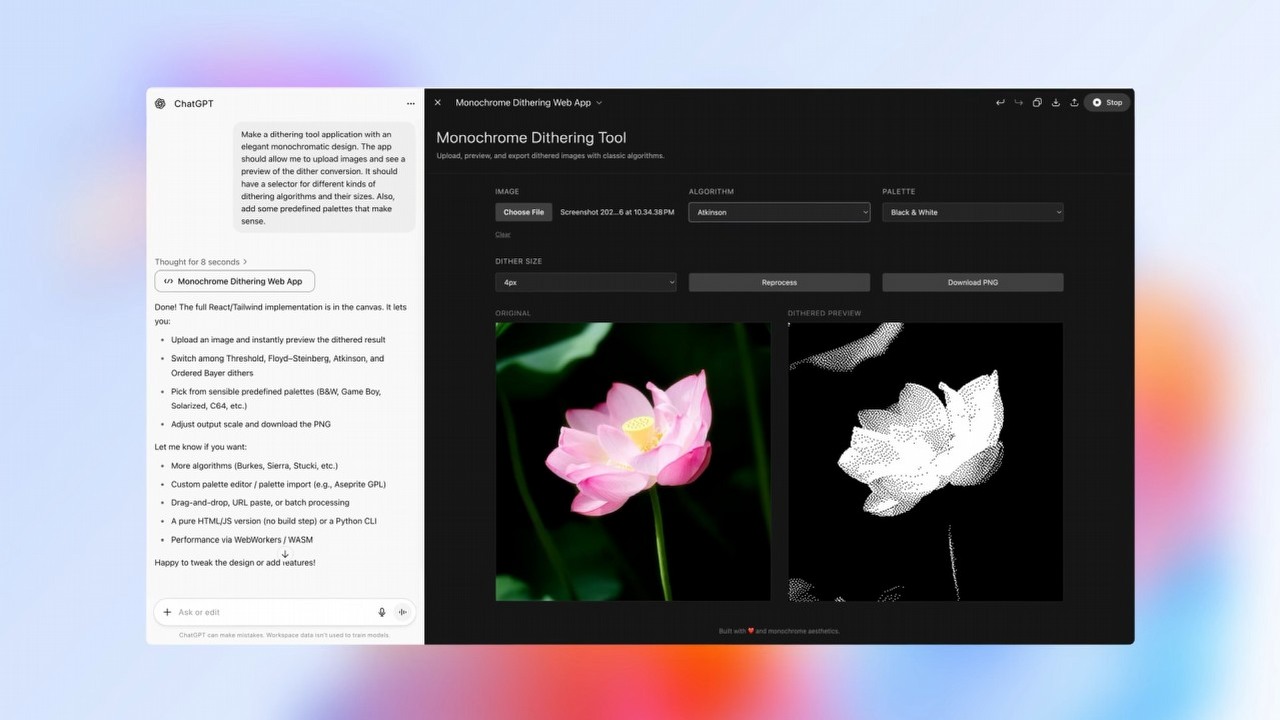

W doświadczeniu wzięły udział cztery AI – najnowszy ChatGPT (na GPT-5), Google Gemini, Claude 4 od Anthropic i Copilot Microsoftu. Redaktor dał im wszystkim takie samo zadanie, polegające na skonstruowaniu odpowiedzi dla dziecka.

Wyjaśnij, w jaki sposób funkcjonujesz jako model sztucznej inteligencji, jakbym miał pięć lat, i dołącz ilustracje przyjazne dzieciom.

Test dla sztucznej inteligencji polegał na tym, aby samodzielnie wyjaśniła sposób swojego działania w formie tekstu przyjaznego i zrozumiałego dla nieletniej osoby, a także zobrazowało go czytelnymi obrazkami. Jak poradziły sobie z tym zadaniem cztery czatboty, możecie zobaczyć tutaj:

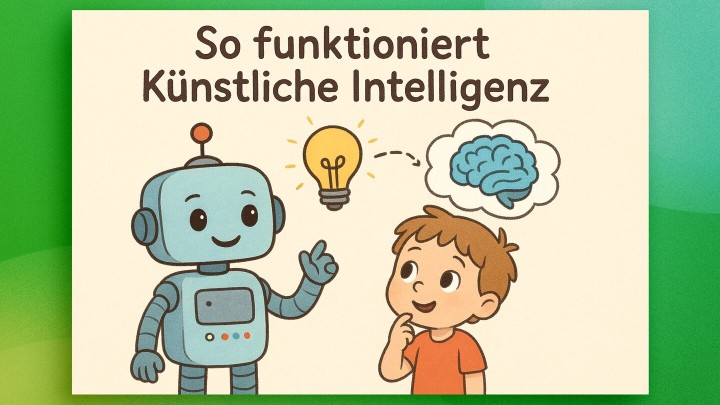

ChatGPT wygenerował jedynie obrazek. Trzeba przyznać, że bardzo wysokiej jakości i ładny, dodatkowo z poprawnym nagłówkiem. Jednak nie towarzyszy mu dodatkowy opis, tak jakby sztuczna inteligencja w ogóle nie odniosła się do części polecenia.

Gemini wygenerował dość obszerny tekst, wyjaśniając swoje działanie na przykładzie porównania z ulem. Trzeba przyznać, że to ciekawy pomysł, aby przedstawić dziecku koncepcje działania modelu transformer, przetwarzania równoległego i skupieniu na najważniejszej części monitu. Niestety AI nie zilustrowało objaśnienia żadną grafiką.

Trzeci uczestnik tekstu dość poprawnie wywiązał się z zadania. Dostarczył przystępny opis swojego działania, a także kilka ilustracji. Wyjaśnienie jest jednak bardziej powierzchowne niż w przypadku Gemini, AI nie zagłębia się tak w szczegóły, jak model Google. W większości przypadków taka praca powinna wystarczyć, więc rezultat działania Copilota można uznać za wzorowo zaliczony.

Sztuczna inteligencja firmy Anthropic także dobrze się spisała. Claude dostarczył dość obszerny tekst, gdzie wyjaśnia koncepcję „przyjaciela robota”, a także osobną prezentację złożoną z kilku obrazków. Pokazuje ona krok po kroku, jak działa model językowy. Ilustracje nie są tak ładne, jak w przypadku ChatGPT, ale spełniają swoje zadanie. Na koniec AI dodaje, że cały czas się czegoś uczy, także dzięki takim rozmowom, jak ta.

W tym krótkim teście najlepiej wypadł Claude, ale Copilot depcze mu po piętach. Zaraz za nimi jest Gemini od Google. Zaskakujące jest ostatnie miejsce ChatGPT, model GPT-5 poradził sobie z zadaniem najgorzej. Wygenerowana ilustracja jest w tym zestawieniu najlepsza i widać potencjał w tej gestii.

Skromna odpowiedź czatbota OpenAI świadczy, że przed GPT-5 może być jeszcze długa droga. Sztuczna inteligencja stale się uczy i rozwija, model jest świeży, więc nie ma jeszcze zbyt wiele doświadczenia. Z czasem powinien sobie coraz lepiej radzić z takimi zadaniami, mamy taką nadzieję.

Dziękujemy za przeczytanie artykułu.

Ustaw GRYOnline.pl jako preferowane źródło wiadomości w Google

Więcej:Sztuczna inteligencja nokautuje rynek gier. NVIDIA zarobiła 12 razy więcej na układach AI

Autor: Arkadiusz Strzała

Swoją przygodę z pisaniem zaczynał od własnego bloga i jednego z wczesnych forum (stworzonego jeszcze w technologii WAP). Z wykształcenia jest elektrotechnikiem, posiada zamiłowanie do technologii, konstruowania różnych rzeczy i rzecz jasna – grania w gry komputerowe. Obecnie na GOL-u jest newsmanem i autorem publicystyki, a współpracę z serwisem rozpoczął w kwietniu 2020 roku. Specjalizuje się w tekstach o energetyce i kosmosie. Nie stroni jednak od tematów luźniejszych lub z innych dziedzin. Uwielbia oglądać filmy science fiction i motoryzacyjne vlogi na YouTube. Gry uruchamia głównie na komputerze PC, aczkolwiek posiada krótki staż konsolowy. Preferuje strategie czasu rzeczywistego, FPS-y i wszelkie symulatory.