Jak byście się czuli, gdyby Sztuczna Inteligencja nagle zaczęła mówić do Was waszym własnym głosem?

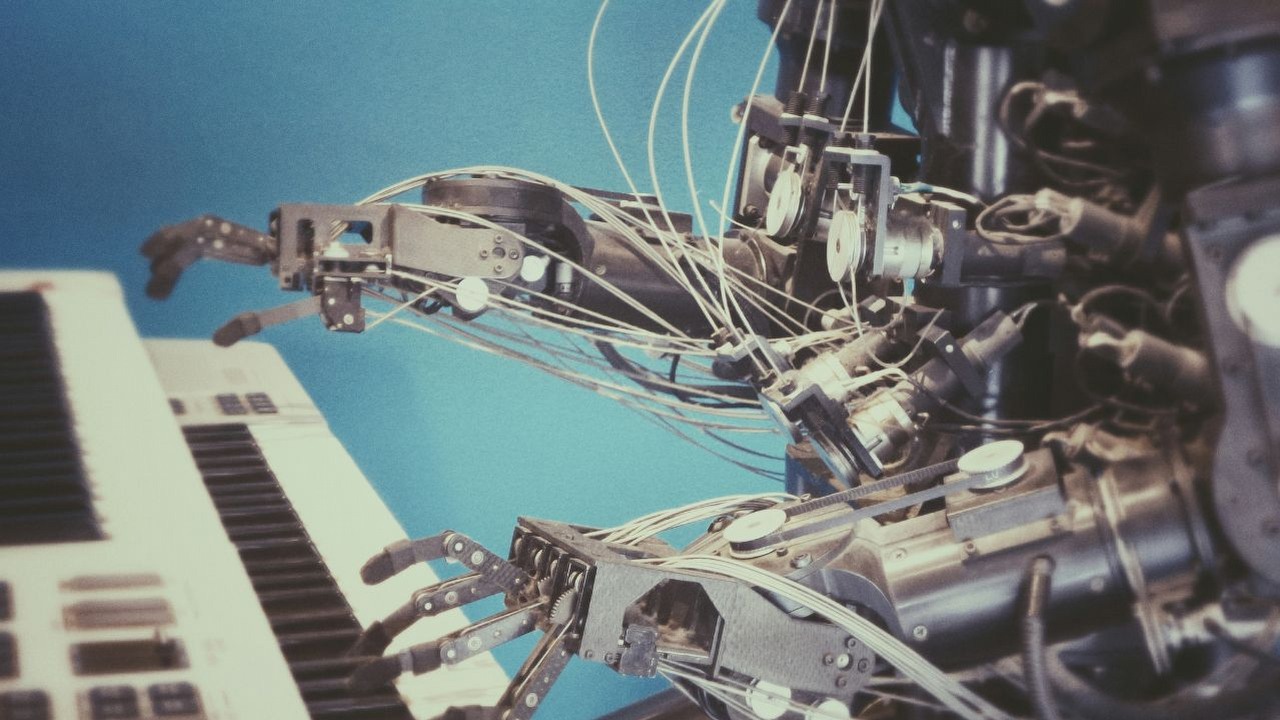

Prace nad ChatGPT trwają. W czwartek OpenAI opublikowało nową kartę systemową, dotyczącą ich najnowszego modelu Sztucznej Inteligencji o nazwie GPT-4o, który ma pozwolić na przeprowadzanie rozmów audio i wideo z asystentem. Model ma między innymi rozpoznawać emocje i odpowiadać na nie, jednak podczas testów pojawiły się nieprzewidziane rezultaty – asystent przemówił własnym głosem użytkownika bez jego autoryzacji (wyraźnej komendy).

Wygląda na to, że bot jest w stanie wygenerować próbkę czyjegokolwiek głosu, bazując tylko na danych treningowych. To samo dotyczy muzyki oraz efektów dźwiękowych.

Chociaż nie jest to pierwszy przypadek wykorzystania Sztucznej Inteligencji do generowania obrazów czy dźwięku, to samo istnienie takiej możliwości budziło i dalej budzi ogromne kontrowersje. Wokaliści czy aktorzy, których wygląd i głosy zostały zreplikowane (np. przez fanów, którzy chcieli usłyszeć ulubione piosenki w wykonaniu nieżyjących już artystów), od początku otwarcie sprzeciwiali się takiemu wykorzystaniu wizerunku i sprowadzaniu ludzkiej kreatywności do zbioru danych, który można łatwo skopiować. Sytuacji nie pomaga fakt, że w dalszym ciągu nie istnieje spójny system prawny, który pozwoliłby na regulację i ograniczenie takich praktyk.

Mimo wszystko, wydaje się, że ta sytuacja była błędem i model po prostu źle zinterpretował komendę użytkownika, co zaskutkowało skopiowaniem jego głosu. OpenAI otwarcie stara się zapobiegać takim przypadkom i wskazuje w karcie systemowej, że model będzie mógł korzystać tylko z domyślnego zestawu głosów, natomiast inne głosy będą blokowane. Pokazuje to jednak, jak złożona i delikatna to sytuacja.

Chociaż wizja wygenerowania dowolnej próbki dźwiękowej jest kusząca, to w praktyce także bardzo niepokojąca. Fanom generowanie kontentu (np. polskiego dubbingu dla ulubionych gier) z pomocą Sztucznej Inteligencji sprawia frajdę – ale co powstrzyma oszustów przed nagraniem np. naszego głosu podczas rozmowy w sklepie i wykorzystaniu go przeciwko nam? Wydaje się, że w tym momencie granice są już konieczne.

Dziękujemy za przeczytanie artykułu.

Ustaw GRYOnline.pl jako preferowane źródło wiadomości w Google

Autor: Danuta Repelowicz

Hiszpańskie serce i japońska dusza. Absolwentka filmoznawstwa ze szczególną słabością do RPG-ów i bijatyk. Miłośniczka wiedzy tajemnej, nauk o kosmosie, musicali i wulkanów. Dorastała na Onimushy, Tekkenie i Singstarze. Wcześniej związana z serwisem GamesGuru, pisze i tworzy od najmłodszych lat. Prywatnie także wokalistka i wojowniczka Shorinji Kempo stopnia 4 Kyu. Specjalizuje się w narratologii i ewolucji postaci. Świetnie porusza się też po tematyce archetypów i symboli. Jej znakiem rozpoznawczym jest wszechstronność, a jej ciekawość często prowadzi ją w najdziksze ostępy umysłu i wyobraźni.