Procesor Apple M1 Max miał wyznaczyć nową jakość w komputerach mobilnych i potwierdzić słuszność decyzji o rozstaniu z Intelem. Pierwsze benchmarki Intel Core i9 12900HK zdają się temu przeczyć.

Apple w czasie prezentacji nowych Macbooków Pro pokazało światu procesory M1 Pro i M1 Max. Ten drugi kreowany był na bezkonkurencyjnego króla wydajności w mobilnych komputerach. Pierwsze benchmarki Intel Core i9 12900HK, do których dotarł serwis Wccftech, pokazują jednak, że nadchodzący procesor „Niebieskich" będzie godnym rywalem M1 Max.

Może Cię zainteresować:

W wydajności jednowątkowej Intel Core i9 12900HK z wynikiem 1851 punktów ma być o 14,5% wydajniejszy od swojego poprzednika, Core i9 11980HK. W stosunku do topowego układu od Apple wydajność będzie wyższa o 3,7%. Niewiele, ale wystarczająco do celów marketingowych.

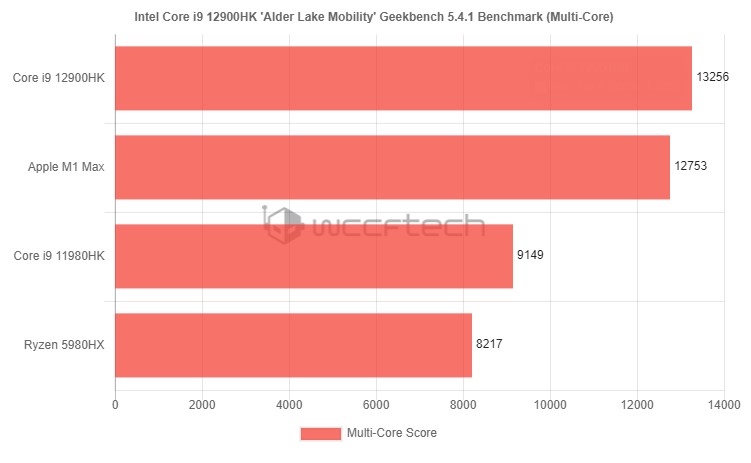

W kwestii wydajności wielowątkowej różnica pomiędzy 11. i 12. generacją mobilnych procesorów Intela jest większa i wynosi aż 45%. Core i9 12900HK osiągnął 13256 punktów. To fantastyczny wynik, który pokazuje, jak ogromny wysiłek musiał zostać włożony, by przebić Apple M1 Max o skromne 3,94%.

Rynek superwydajnych procesorów mobilnych jest dość specyficzny. Dla graczy często większe znaczenie ma karta graficzna, wielu profesjonalistów wybierze rozwiązanie stacjonarne ze względu na wygodniejszą pracę. Nisza jest jednak dość prestiżowa, a tytuł króla mobilnej wydajności zdaje się mieć znaczenie bardziej wizerunkowe niż ekonomiczne. Tym gorzej dla Apple, że zasiada w innym, niebieskim zamku.

Dziękujemy za przeczytanie artykułu.

Ustaw GRYOnline.pl jako preferowane źródło wiadomości w Google

53

Autor: Konrad Sarzyński

Od dziecka lubił pisać i zawsze marzył o własnej książce. Nie spodziewał się tylko, że będzie to naukowa monografia. Ma doktorat z rozwoju miast, czym chętnie chwali się znajomym przy każdej możliwej okazji. Z GOL-em przygodę zaczął pod koniec 2020 roku w dziale Tech. Tworzył teksty, prowadził newsroom technologiczny, a później współtworzył portal Futurebeat.pl, odpowiadając za publicystykę i testy sprzętów. Obecnie skupia się na wszelkiego rodzaju builderach - zarówno tych mainstreamowych, jak i całkowicie niszowych - które ogrywa na swoim kanale na Twitchu. Mieszka z kotem i żoną.