Pojawiły się kolejne doniesienia dotyczące układu RTX 4080. Potwierdzają one wcześniejsze wiadomości na temat prądożerności kart z generacji Ada Lovelace.

Źródło fot.: Unsplash / Jose G Ortega Castro

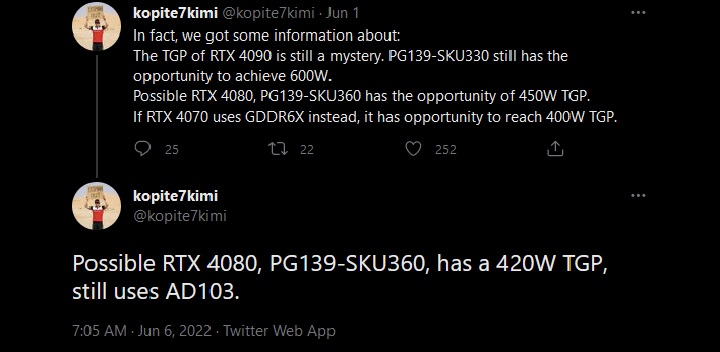

Informację o wysokim poborze energii karty graficznej GeForce RTX 4080 podał znany leakster kopite7kimi. Napisał on na Twitterze (via Hothardware), że układ ten będzie korzystał z płyty PG139-SKU360, a współczynnik TGP (Total Graphics Power) ustalony został na 420W.

Oznacza to, że wartość ta będzie wyższa o 100W niż w przypadku GeForce’a RTX 3080, którego TGP wynosiło 320W. Jednocześnie będzie to jedynie 30 W mniej od rzekomego TGP topowego GeForce'a RTX 4090.

Może Cię zainteresować:

Warto przypomnieć, że GeForce RTX 4080 bazować ma na rdzeniu AD103, który ma być słabszy od AD102, wykorzystywanego w RTX-ach 4090. Znikoma różnica w TGP pomiędzy tymi układami może sugerować, że różnice między rdzeniami będą niewielkie. Co jednak oznacza to w praktyce?

Przede wszystkim zbliżoną wydajność obu GPU. Ponadto spełnienie takiego scenariusza może spowodować, że firmy tworzące karty graficznych z obydwu serii będą mogły stosować te same chłodzenia dla obu modeli.

Na tę chwilę nie ma zbyt wielu oficjalnych informacji na temat tego układu. Wiemy jedynie, że ma on bazować na rdzeniu AD103, który ma zaoferować 10 752 rdzenie CUDA, a także 16 GB VRAM o prędkości 21 Gb/s na 256-bitowej szynie danych, co da przepustowość na poziomie 672 GB/s.

Karty graficzne Nvidii kupisz tutaj

Zdecydowanie mocniejszą propozycją ma być RTX 4090. Flagowy układ graficzny ma zawierać 16128 rdzeni CUDA oraz 24 GB pamięci GDDR6X o prędkości 24 Gb/s. Całość ma przełożyć się na przepustowość na poziomie 1 TB/s.

Czy jednak tak będzie przekonamy się w drugiej połowie 2022 roku. To właśnie wtedy, zgodnie z wcześniejszymi informacjami, mają na rynku zadebiutować karty graficzne z serii RTX 4000.

Dziękujemy za przeczytanie artykułu.

Ustaw GRYOnline.pl jako preferowane źródło wiadomości w Google

Więcej:Gracz kupuje płytę główną za 180 zł, a dostaje sprzęt wart około 8 500 zł za darmo

8

Autor: Marcin Nic

Przygodę z pisaniem zaczął na nieistniejącym już Mobilnym Świecie. Następnie tułał się po różnych serwisach technologicznych. Chociaż nie jest typowym graczem, a na jego komputerze znajduje się tylko Football Manager, w końcu wylądował w GRYOnline.pl. Nie ma dnia, w którym nie oglądałby recenzji nowych smartfonów, dlatego początkowo pisał o wszelkiego rodzaju technologii. Z czasem jednak przeniósł swoje zainteresowania bardziej w kierunku kinematografii. Miłośnik NBA, który uważa, że Michael Jordan jest lepszy od LeBrona Jamesa, a koszykówka z lat 90-tych była przyjemniejsza dla oka.