AMD rzuca wyzwanie Nvidii wraz z prezentacją nowego chipu AI przeznaczonego do zaawansowanych zadań. Model MI300X jest o 50% szybszy od konkurencji i może obsługiwać dwukrotnie więcej pamięci HBM3.

W dniu 13 czerwca odbyła się prezentacja, podczas której Lisa Su, prezes AMD pokazała rywala dla układu NVIDIA H100, przeznaczonego do zadań związanych ze sztuczną inteligencją. Nowa jednostka nazywa się Instinct MI300X, bazuje na architekturze CDNA 3 i stanowi część platformy MI300A. Producent twierdzi, że jest to 50% szybszy układ od swojego bezpośredniego konkurenta oferowanego przez Nvidię.

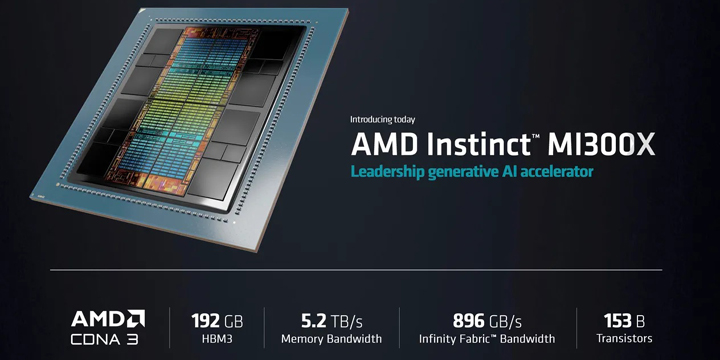

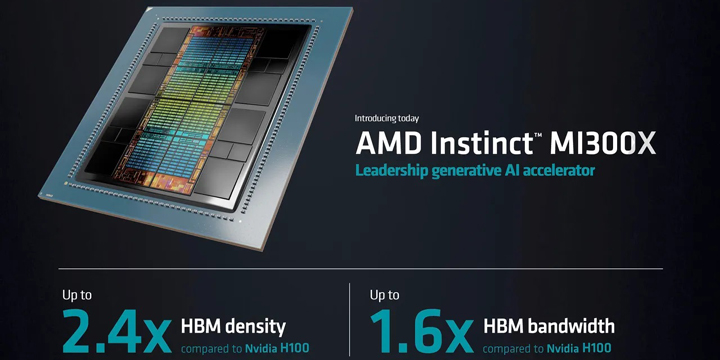

Nowy chip składa się ze 153 mld tranzystorów, posiada 16 tys. jednostek obliczeniowych, a także może obsługiwać aż 192 GB pamięci HBM3 o przepustowości 5,2 terabajta na sekundę. Jest kombinacją pojedynczych chipów, połączonych w jednym pakiecie za pomocą współdzielonej pamięci i łączy sieciowych. MI300X zaoferuje 2,4 razy większą gęstość pamięci niż procesor graficzny Nvidia H100 i 1,6 razy większą przepustowość.

Firma twierdzi, że jak dotąd jest to jej najbardziej zaawansowany procesor AI, wystarczająco mocny, aby obsługiwać dużą sieć neuronową całkowicie we własnej pamięci, bez konieczności przenoszenia danych do zewnętrznych nośników. Pojedyncza jednostka jest w stanie obsłużyć modele zawierające do 80 mld parametrów.

Chip powstał przede wszystkim do zastosowań konsumenckich, takich jak centra danych, usługi w chmurze, a także instytuty badawcze. Zaprojektowano go do różnego rodzaju zastosowań związanych ze sztuczną inteligencją, jak przetwarzanie języków naturalnych, wizje komputerowe oraz uczenie maszynowe. Jednostka będzie więc w stanie zredukować koszty wdrożenia sztucznej inteligencji, poprawić elastyczność i skalowalność infrastruktury, a także zwiększyć jej bezpieczeństwo.

Producent dla nowego chipa przygotował także oprogramowanie w postaci ROCm. Jest to platforma typu open source, dzięki której programiści mogą tworzyć oraz uruchamiać aplikacje oparte na sztucznej inteligencji.

AMD liczy na to, że stanie się realną konkurencją dla Nvidii na rynku akceleratorów sztucznej inteligencji, którego wartość ciągle rośnie. Tylko w tym roku szacuje się ją na 30 mld dolarów, jednak w 2027 roku ma wzrosnąć do już 150 mld dolarów. Wprawdzie producent na razie nie zdradził ceny układu Instinct MI300X, jednak ma być ona konkurencyjna wobec chipa Nvidia H100.

Dziękujemy za przeczytanie artykułu.

Ustaw GRYOnline.pl jako preferowane źródło wiadomości w Google

13

Autor: Marek Pluta

Od lat związany z serwisami internetowymi zajmującymi się tematyką gier oraz nowoczesnych technologii. Przez wiele lat współpracował m.in. z portalami Onet i Wirtualna Polska, a także innymi serwisami oraz czasopismami, gdzie zajmował się m.in. pisaniem newsów i recenzowaniem popularnych gier, jak również testowaniem najnowszych akcesoriów komputerowych. Wolne chwile lubi spędzać na rowerze, zaś podczas złej pogody rozrywkę zapewnia mu dobra książka z gatunku sci-fi. Do jego ulubionych gatunków należą strzelanki oraz produkcje MMO.