Karty graficzne RTX 50 otrzymają nową architekturę, ale poczekamy do 2025 roku

Hehe.

Tak piszą tylko ludzie, którzy nie mieli 4xxx w rękach.

Ja uważam, że to najlepsza seria od dawna.

Pomijając już spory skok wydajnościowy, to nieważne, czy kupisz jakąś gunwo wersję 4080, czy topowego Suprima - i tak będziesz miał CICHO.

Jako wręcz fanatyk wodnych chłodzeń, po kilku dniach od zakupu swojej 4080 (a kupiłem FE na premierę), przestałem szukać wodniaka. Nie ma to sensu. Te karty to po prostu ultra ciche. Cewki ledwo słyszalne jak włożę głowę do budy.

W UWQHD full detale w żadnej grze nie miałem więcej jak ok. 1400 rpm wentyli na karcie - oczywiście UV obowiązkowe.

Przykro mi, ale nie mogę się z Tobą zgodzić.

Kupiłem RTX 4070 12 GB całkiem od niedawna za okazjonalna cena (około 2500 zł) i miałem okazję testować Frame Generation osobiście na Cyberpunk 2077 i Ratchet & Clank Rift Apart. Artefakty graficzne wcale nie uświadczyłem. Żeby coś takiego zauważyć, to naprawdę trzeba namęczyć oczy. Jeśli są jakieś widoczne artefakty (np. migotające obiekty), to raczej wina niedopracowany DLSS lub FSR, które zostaną naprawione wraz z aktualizacji (np. DLSS 1.0 -> DLSS 2.0 i tak dalej), czego było widać w grze Control.

DLSS 3 to tak naprawdę kombinacja DLSS 2 i Frame Generation. Ta nowa technologia robiło na mnie duże wrażenie. Można włączyć Frame Generation bez DLSS 2 i odwrotnie, ale to zależy od opcji graficzne w niektórych grach.

RTX 4070 12 GB bez DLSS 3 jest prawie dwa razy lepszy od RTX 3060, więc nic nie stracę na to.

Po prostu w ogóle nie miałeś RTX 4000 w rękach i nie testowałeś DLSS 3. Więc proszę nie wprowadzaj innymi w błąd.

to już kwestia indywidualna. To, że Ty nie widzisz artefaktów to nie znaczy, że ich nie ma.

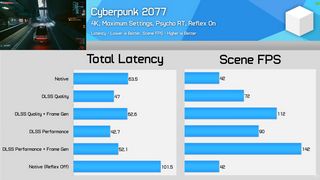

Ponadto cóż z tego, że licznik pokazuje Ci 100 fps jeżeli realnie nadal grasz na opóźnieniach jak dla 60fps?

No i czemu porównujesz 4070 do 3060 skoro ta karta kosztuje 3x tyle? Nawet 3070 jest sporo wydajniejsza od 3060, a 4070 ma wydajność 3080. Ogólna zasada jest taka, że x80 too 100% wydajności a x60 to 50% wydajności. Niestety w generacji 4 coś im nie pykło i to 60ti stanowi te 50%, a 60 to raczej 40%.

gdzie ta lepsza wydajność? Bo na pewno nie tu https://i.imgur.com/65Yx1WX.png

Chyba, że wg Ciebie 4070 jest lepsza od 3070. Bo jest. Tyle, że jest przy tym droższa. A co za tym idzie wydajność za 1pln jest taka sama.

Szkoda tylko, że x70 poprzednich generacji były 16-29% wydajniejsze od x80 generacji minus jeden, a przy tym były tańsze. Tutaj masz x70 o wydajności x80 w cenie x80. Rewolucja XDDD

pieterkov -> nie zgodzę się, że te dodatkowe generowane klatki przez frame generation są do D. Zanim miałem okazję się tym pobawić też miałem bardzo sceptyczne podejście do tego tematu, ale testując to samemu na prawdę to daje radę. Artefakty w ogólnym rozrachunku jasne, że są bo kłamstwem by było napisać, że ich nie ma, ale serio jak zaczniesz grać a nie robić stop klatki to w zasadzie tego nie widać, zaliczyłem m in 50h godzin w cyberpunku z włączonym dlss3 i było bardzo spoko. Większym problemem dla mnie było właśnie odczuwanie dodatkowego opóźnienia dlatego z włączonym dlss3 celowałem w okolice przynajmniej 80fps bo przy takiej wartości opóźnienie było dla mnie bez problemu akceptowalne. Zresztą to są rzeczy, do których szybko adaptuje się człowiek. Warto samemu to ocenić nie poprzez filmy i komentarze na yt itp.

Co do ostatniego zarzutu można ująć temat inaczej. Mając do wyboru granie w 60fps i opóźnieniach jak przy 60fps albo granie w 100fps i opóźnieniach jak przy 60fps co wybierasz? Ja wybieram bramkę nr 2. Nie mówię, że jest to technologia bez wad, ale ma to perspektywę przed sobą jak i już jest w mojej opinii bez problemu używalne w grach.

fenfir - no ja wybieram 60/60 a nie 60/100. Dlaczego? Bo oczy się mniej męczą. Często w grach świadomie rezygnuję nawet z DLSS 2 bo wolę mieć mniej FPS za to ostrzejszy, mniej rozmazany obraz bez artefaktów. Oni do tej pory nawet dlss 2 nie zrobili dobrze w wielu grach, a co tu jeszcze mówić o dokładaniu sztucznych klatek :P

Ogólnie z samą technologią problemu nie mam. Fajny bajer, jak ktoś chce to niech używa. Podobno działa to dobrze, gdy ze 100fps zrobimy 200, bo różnica w input lagu nie jest tak znacząca.

Problem w tym, że w ten sposób fałszuje się wyniki, a ludziom sprzedaje się to jako klatki z powietrza. Myślą, że nagle z 40fps zrobią sobie bez żadnych wad 80fps, czyli wg nich karta jest wydajniejsza i warto na nią wyłożyć 3000zł. A to jest po prostu okłamywanie klientów. Jeżeli nvidia będzie dalej wstrzymywać postęp w ten sposób to będę musiał poważnie zastanowić się nad swoim fanbojstwem pro-nv i pomyśleć nad przesiadką na AMD :/

fenfir - no ja wybieram 60/60 a nie 60/100. Dlaczego? Bo oczy się mniej męczą. Często w grach świadomie rezygnuję nawet z DLSS 2 bo wolę mieć mniej FPS za to ostrzejszy, mniej rozmazany obraz bez artefaktów. Oni do tej pory nawet dlss 2 nie zrobili dobrze w wielu grach, a co tu jeszcze mówić o dokładaniu sztucznych klatek :P

Ja też wolę ostrzejszy obraz bez DLSS 2. Ale jeśli mam wybrać 30 FPS a 60 FPS z DLSS 2, to wolę te drugie. 30 FPS bardziej męczą oczy.

DLSS 2 to coś więcej niż tylko "zmniejszenie rozdzielczość". Poprawi obrazu po zmniejszenie rozdzielczość dzięki sztuczne inteligencji i takie tam, więc utraty jakość jest prawie niezauważalny, ale to już zależy od tytułu gry i styl graficzny. Nie wszystkie tytuły mają dopracowane DLSS lub FPS. Czasem DLSS u Resident Evil 4 wygląda lepiej niż FPS, bo nie było widać artefakty.

Rozmazany obrazu? Porównałem Cyberpunk 2077 z DLSS 2 jakość i bez tego. Jestem zdziwiony, że różnica jest prawie nie do zauważenie poza więcej FPS.

Nie twierdzę, że DLSS 2 i Frame Generation nie mają efekty uboczne. Zawsze będą. Ale to trudno jest zauważyć. To zależy od wyboru rozdzielczość i gry. Nie wszystkie gry mają idealne działające DLSS lub FSR, ale to zależy od wersji.

No, DLSS 2 wydajność i balans nie jest wskazany i nie warto w moim odczucie. DLSS 2 jakość jest jedyna, słuszna opcja, jak masz poniżej 40-50 FPS. Frame Generation jest alternatywna rozwiązania, jak ktoś nie chce DLSS 2. Połączenie DLSS 2 i FG ma sens tylko wtedy, jak ktoś chce grać na 4K.

To twój wybór. Każdy ma wybór, czy chce korzystać z tego.

Ale modlę się, żeby twórcy gier nie za bardzo polegają na DLSS. Oby nie idą za śladem Remnant 2, gdzie DLSS 3 jest obowiązkowy.

Przy okazji, pytam Cię, czy masz RTX 3000 lub 4000? Czy wypróbowałeś DLSS 2 i 3 w różnych grach?

Jaki rozdzielczość dla monitora wybrałeś? Pytam to z ciekawostki dla nauki.

Prawda. Jak ktoś ma RTX 3070, to zakup RTX 4070 za prawie 3000 zł jest zdecydowanie nieopłacalny. Ale jeśli ktoś ma RTX 3060, a cena RTX 4070 będzie to 2000-2500 zł, to byłaby inna bajka.

Popatrz sobie na wyniki wydajności np. tutaj 4070 vs 3070 vs 2070

https://www.purepc.pl/test-karty-graficznej-msi-geforce-rtx-4070-gaming-x-trio-dobrze-chlodzona-i-bardzo-cicha?page=0,31

(3070 ma 30 pp większą wydajność za ok. 2400zł niż 2070 za 2300zł)

lub tutaj 2070 za 2300zł vs 1070 za te same pieniądze - wzrost 33%:

https://www.purepc.pl/test-nvidia-geforce-rtx-2070-szybszy-od-geforce-gtx-1080?page=0,8

https://www.purepc.pl/test-nvidia-geforce-rtx-2070-szybszy-od-geforce-gtx-1080?page=0,6

i dopiero tutaj sytuacja przypominająca obecną 4 generację, jednoczesny wzrost wydajności (prawie 50%!), ale też ceny z 1500 na 2300zł. Wzrost wydajności, był jednak na tyle duży, że nadal się opłacało:

https://www.purepc.pl/test-geforce-gtx-1070-nastepca-gtx-970-szybszy-niz-gtx-980-ti?page=0,5

I boli mnie to, że ta karta ma 3 lata i nadal nie ma nic bardziej opłacalnego. Na 4060ti nie ma sensu się przesiadać bo jest GORSZA, a 4070 to ta sama wydajność co 3070, tylko, że mogę dać więcej pieniędzy, żeby dostać więcej fps, ale po podobnym przeliczniku. To tak jakby zamiast 3070 kupić 3080...

Z drugiej strony ten sam problem miałem z 1070, więc pozostaje mi po prostu cierpliwie czekać 2 lata na premierę 5060ti i modlić się, żeby do tego czasu ludzie nie zaczęli wykupywać wszystkich GPU z rynku do AI.

DLSS 2 używam tylko wtedy kiedy muszę, bo gra jest słabo zrobiona np. steelrising. Używam go też gdy nie widać żadnych jego wad, bo czasem po prostu zmniejsza input lag zerowym kosztem.

Niemniej, uważam, że DLSS to główny powód plagi lenistwa i gdyby ta technologia nie powstała, rynek gier miałby się lepiej. Patrząc chociażby po Twoim przykładzie z remnant 2.

Nie dziwię się i to zrozumiałe. Jeżeli masz RTX 3070, to nie widzę powodu, by przenosić się na RTX 4060 Ti lub RTX 4070, bo to jest zdecydowanie nieopłacalny. Na DLSS 3 lepiej nie można polegać, bo nie działa idealnie u wszystkie gry, a niektóre tytuły są celowo zablokowane dzięki nieuczciwe umowie AMD. Lepiej jest poczekać na RTX 5000.

Na pocieszenie, RTX 3070 jest bardzo dobra karta i wystarczająca na wszystkie gry (prawie), więc nic nie stracisz.

Ja kupiłem RTX 4070 tylko dlatego, że różnica w porównaniu do mojego poprzednika RTX 3060 jest bardzo odczuwalna i to za okazjonalna cena. Traktuję DLSS 3 tylko jako miły dodatek, a nie główny argument do zakupu. To zależy od posiadana karta i cena.

Jeśli karta będzie za słaba dla wybrany tytuł, to pozostaje tylko DLSS. To zawsze lepsze niż opcji graficzne na Medium/Low. DLSS jest odczuwalny lepszy niż zwykły obniżony rozdzielczość w sposób tradycyjny (dużo pikseli, bardziej rozmazane tekstury). Używam DLSS, kiedy tylko muszę. Bez DLSS nie ma sensu jest wypróbować Path Tracing dla Cyberpunk 2077.

uważam, że DLSS to główny powód plagi lenistwa i gdyby ta technologia nie powstała, rynek gier miałby się lepiej

Wątpię. To zależy od twórcy gier. Niektórzy traktują optymalizacji gier z powagą, a inni wykorzystują DLSS 3 jako wygodna wymówka na olewanie optymalizacji (pluję na twórcy Renmant 2, błe, tfu).

To tak jakby napisać, że gdyby nie powstają mocniejsze karty graficzne, to rynek gier miałby się lepiej.

Gdyby nie powstało DLSS, to tak powstają mocniejsze karty graficzne, ale za znacznie wyższe ceny, a twórcy gier nadal będą leniwi i pójdą na łatwiznę, czego to było widać po niektóre gry za czasów karty GTX. Wtedy niektóre gry nie da się grać na RTX 3000.

DLSS powstał z myślą o użycie RT dla rozdzielczość 4K (lub 1440p) i to jest główny powód. Bez DLSS, to RT byłby nieopłacalny dla większości gracze.

Czy chcesz, by twórcy gier będą dawać sporo downgrade do grafiki gry podobnie jak Watch Dogs 1, żeby móc działać na 4K, bo to obowiązkowy standard? Jeśli mam wybrać, to wolę DLSS niż odczuwalny downgrade dla grafika gry. Taka jest cena moda 4K i ray tracing.

Ray tracing może wygląda cudownie u Cyberpunk 2077, Spider-Man i Watch Dogs Legion (te odbicie wody i lustro), ale dla wielu gry RT to po prostu przereklamowany i zbędny dodatek. Świetnie to było widać po Elden Ring.

To zależy od twórcy i silniki gry. Bywają różne.

Ale masz rację. DLSS jeszcze nie jest idealny i lepiej będzie dla wszystkich, jak twórcy gier nie za bardzo polegają na DLSS.

Ale gdyby nie powstaje DLSS, to twórcy gier nadal będą leniwi w kwestii optymalizacji. Ale na szczęście DLSS i FSR z upływem czasu są coraz bardziej dopracowane i mają coraz mniej artefakty graficzne. Czas pokaże.

Życzę Ci miłego grania.

Ja tu raczej widzę duży ból tyłka. Że kogoś nie stać na kartę. Równie dobrze można napisać. Że nie opłaca się produkować Ferrari Bugatti i Rolls-Royce. Bo tylko bogaci jeżdżą tymi markami, a to tylko 1% społeczeństwa. Więc trzeba je wszystkie niszczyć. I piętnować takich ludzi.

Też na początku roku wskoczyłem na rtx 3060ti i na tym pozostanę spokojnie do 25 jak nie dłużej ;)

Ja 2 tygodnie temu też na RTX 3060 Ti sie przesiadłem z GTX 1060 6GB(pominołem serie GTX 1600 i RTX 2000).Rożnica spora w wydajnosci,tylko wiatraki jaskieś takie głosniejsze:)

Ja też, od roku na 3070 i na razie jest ok a seria 4000 to pomyłka, poczekam na 5

Przepłaciłem za swojego rtx3060ti w tamtym roku ale do dzisiaj nie żałuje wyboru nawet jak staniał o prawie 600zł

Nie ma co się dziwić. RTX 3060 Ti to bardzo dobra karta i wystarczy na większości gry tak jak GTX 1060 w tamtędy czasach.

Życzę Wam dużo radości w odkrywanie nowe gry.

A ja planuję przesiadkę na 4070. Coś czuję, że to i tak będzie tańsze i lepsze rozwiązanie niż czekanie na 5060Ti.

No to czekamy na te karty o mocy takiej, jaką powinny mieć karty serii 40, w tej samej cenie, tylko 3 lata później.

I co teraz zrobić jak planuję nowego peceta składać w 2024, rtx 2070 w 1440p już za bardzo nie wyrabia

kupisz to co będzie najbardziej opłacalne. 3070 są usuwane ze sklepów więc pewnie co najwyżej 4060ti lub 4070.

Równie dobrze możesz obstawić ze polska reprezentacja piłki nożnej zacznie wygrywać mecze

Dokładnie spokojnie się nadaje do 1440p u mnie RTX 3080 jak znalazł. Brakuje troszkę VRAM'u na przyszły rok ale jakoś to będzie.

Nawet do 4k bez problemu, ale bez technologii śledzenia promieni. Pozdrawia rtx 3080 12GB.

Jeszcze mają zapasy magazynowe serii 3000 z czasów davida19. Więc tanio skóry nie sprzedadzą.

Najbardziej opłacalna GIGABYTE GeForce RTX 3060 Ti WINDFORCE OC 8GB.

Jeśli ktoś kupuje karty Gigabyte, to zdecydowanie polecam wspornik/uchwyt do karty takich jak ten:

https://www.x-kom.pl/g-5/c/3510-uchwyty-do-karty-graficznej.html

Bo karty Gigabyte nie są dość wytrzymałe i mogą się łamią pod wpływem ciężarem (lub ktoś nie obchodzi z karty delikatnie), a oni nie dają gwarancji za to.

https://www.telepolis.pl/tech/sprzet/gigabyte-karty-graficzne-awaria-zlamane-pcb

Ktoś, kogo znam, używa uchwyt do karta Gigabyte od wielu miesięcy i nie ma problemu z tym.

Uchwyty do karty graficzne to podstawa w dzisiejszych czasach, jak patrzę na rozmiary i waga karty.

Ja używam prętów wolframowych są dużo tańsze i pisz poprawnie po polsku, a nie bez ładu i składu.

Lub można karyty graficznyej zamontowaność w pionowy pozycjii.

Proszę uważaj z tym słowem, bo ktoś może Cię zgłosić na panelu. To, że nie pasuje Ci takie rozwiązanie nie znaczy, że daje Ci prawo do obrażanie innymi. Szczególnie do osoby, co mają mniej szczęście w kwestii zdrowotne. Trochę grzeczniej.

Ja wybrałem taki:

https://www.x-kom.pl/p/582327-uchwyt-do-karty-graficznej-jonsbo-uchwyt-do-karty-graficznej-vc-1-czarny.html

i nie mam z tym problemu. Jestem bardzo zadowolony. No, to kwestia gustu.

Twój wybór też nie jest źle. To zależy od modelu karty graficzne i obudowy.

Miłego dnia.

A jak z przepływem powietrza i temperaturą z kartą w ten sposób zamontowaną, że pionowo?

tynwar

Dobre pytanie.

Jeśli chodzi o mnie, to nie mam problemu z temperatury nawet, kiedy CPU i GPU są pełne obciążone. Temperatura jest akceptowalna (50 stopni C przy pełne obciążenie).

Ale jeśli chodzi o moja karta graficzna Gigabyte, to nie może być pionowy, bo przecież musi gdzieś wyrzucić ciepłe powietrze. Załączam tu zdjęcia.

Więc rozwiązania Alba Longa w moim przypadku raczej odpada. To zależy od modelu karty graficzne i obudowy.

To rozwiązanie spisuje się wyśmienicie - od czego są wentylatory w obudowie.

Chcesz to zgłaszaj, a nie strasz. Wykonanie takiej podpórki to koszt maks 20zł.

A ty spamujesz jakieś linki co można kupić u chińczyków na ali.

Chyba, że masz z tego prowizję to jeszcze zrozumiem.

Nie obrażam Ciebie Szanowny Kolego tylko wyrażam swoje zdanie o tym przedmiocie.

Kupiłem plastikową kieszeń na dyski twarde to śmierdziało nie wiadomo czym i po kilku dniach 5€ poszło do śmietnika. Szkoda tylko czasu przestoju komputera BOINC i czasu montażu.

Chcesz to zgłaszaj, a nie strasz.

Nie muszę. Ale ktoś może to zrobić. Tylko ostrzegałem.

A ty spamujesz jakieś linki co można kupić u chińczyków na ali.

Podałem tylko przykłady, jeśli chodzi o podpórki. Nie każdy to wie, że coś takiego istnieje. Ale kto i gdzie kupuje, to jego sprawa i jego pieniędzy. Nie musi to sklep x-kom, ani te wybrane produkty.

Nie obrażam Ciebie Szanowny Kolego tylko wyrażam swoje zdanie o tym przedmiocie.

Co z tego, że wyraziłeś własne zdanie, skoro pisałeś do mnie w sposób niegrzeczny. Widzę, że już edytowałeś post, ale doskonale wiesz, co napisałeś, więc mnie nie oszukujesz. Bez odbioru.

Możliwe, ale to w dalszym ciągu jest jednak rozwiązanie dla niektórych modeli, więc nie jest to uniwersalne rozwiązanie.

To rozwiązanie spisuje się wyśmienicie - od czego są wentylatory w obudowie.

Zapomniałem coś dodać. Dopóki mam akceptowalna temperatura dla CPU i GPU, to nie muszę uciekać do Twojego rozwiązania. Chyba że ktoś woli, by wnętrza obudowa będzie tak wyglądać dla podziwianie. To kwestia gustu i podzespoły PC.

Ale z drugiej strony, twoje rozwiązanie są dobre dla karty graficzne, co wymagają wtyczki 12-pin, a obudowa nie jest wystarczająca szeroka, by podłączyć kabel w sposób bezpieczny (kabel nie może być zgięty poniżej minimalny długość).

Nie bez powodu wybrałem Gigabyte RTX 4070 Eagle, a nie inne marki i modeli, ponieważ obsługuje tradycyjny 8-pin, co sprawi, że nie muszę wymieniać zasilacz do PC (co dopiero kupiłem od niedawna) na nowy ze standardem ATX 3.0.

Wszystko ma swoje zalety i wady.

Miłego grania.

Tak nowe jeden i ten sam plastik z elektroniką co przynajmniej 10 lat temu tylko cyferki zmienią w sterownikach, systemie tak wygląda rzeczywistość.

.

Podobno RTX 5060 będzie miał wydajność 4090, a 5090 będzie wydajniejsze od 4090 o 120%

Podobno RTX 5060 będzie miał wydajność 4090

Albo RTX 5060 będzie miał wydajność 4060 plus nowa technologia dla VRAM i wsparcie AI na bonus za wyższa cena. :>

Czas pokaże.

Jestem za tym by do 2025 roku uklady owe nie powstaly,ludzie z uposledzenia technika zaczeli wkoncu swoim mózgiem myslec o ile jeszcze cos takiego jak mózg posiadaja i licze ze nie bedzie z czego techniki robic gdyz zycze sobie zeby wogóle z ludzkiego Zycia dla zdrowia znikneła dla psychiki to dobre i dla ciala

Wam juz nic nie pomoze.Wasze zindoktrynowanie wam nie pozwoli sie wyrwac.

Pozatym was ciagnie do rtx mnie nie.wy co jakis czas kupujecie to i owo do kompa.Jesli mi zydsoft bedzie wciskal ai moj kompek leci z chukiem za okno.I kto na tym zdrowiej wyjdzie.Wam znowu wcisną kit bajere i ja lykniecie.A ja sobie bede zyl po swojemu bez wplywu kogokolwiek kto zechce probowac mi wcisnac nowomode ktorej wy nie odmowicie.Powiedz,ze sie myle?

Jest tyle ludzi na świecie, że tylko technika wykorzystana w właściwy sposób im pomoże. Np. przewidywanie pogody i siewy w odpowiednim czasie.

Jesli za tym stoja ludzie.Jeszcze.Bo jak to przejmie AI to bedzie cyrk.Wasz nie moj.Pozatym ludzie z roku na rok coraz glupsi,a zgadnij z jakiego powodu?Co sie przyczynia do pogarszajacego sie stanu umyslowego ludzi na swiecie?Pamietaj o tym,jak za dziesiec lat ani nic nie napiszesz ani nic nie powiesz.Bo ai bedzie toba zarzadzac.Dzieki tobie zreszta.Bo na to dales zgode i przyzwolenie

Fajnie, tylko, że u ciebie ilość błędów językowych jest tak przerażająca, że tobie już nic nie pomoże.